Praktické aplikace modelu Llama-3.1 405B

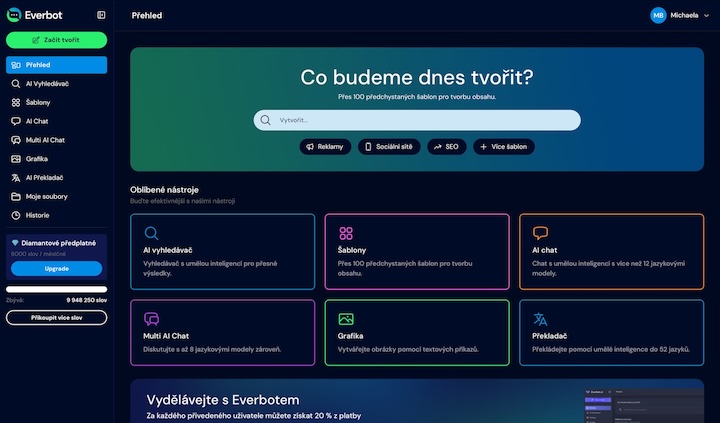

27.11.2024S nadšením oznamujeme spuštění naší unikátní aplikace pro tvorbu obsahu, která přináší revoluci do světa digitální kreativity. Tato inovativní platforma umožňuje uživatelům snadno a rychle vytvářet profesionální texty, grafiku a multimediální materiály. Díky intuitivnímu rozhraní a pokročilým nástrojům je tvorba obsahu přístupná jak začátečníkům, tak zkušeným tvůrcům. Naše aplikace slibuje zvýšení produktivity a kvality výstupů, což ocení jednotlivci i týmy. Vyzkoušejte ji ještě dnes a objevte nové možnosti kreativní práce!

Generování syntetických dat: Úloha Llama-3.1 405B

Jedním z klíčových využití modelu Llama-3.1 405B je generování syntetických dat, což je důležité především v situacích, kdy je dostupnost reálných dat omezená nebo nákladná. Syntetická data generovaná tímto modelem mohou být použita pro:

Model s tak velkým počtem parametrů a rozsáhlým kontextem dokáže syntetická data přizpůsobit konkrétním úkolům a oborům, což přispívá k jejich realistickému a přesnému charakteru. Například firmy vyvíjející chatboty mohou generovat data simulující konverzace s klienty, což přispívá ke zlepšení a optimalizaci výstupů při finálním nasazení.

Distilace znalostí a trénink menších modelů

Další významnou aplikací je distilace znalostí z modelu Llama-3.1 405B do menších modelů. Tento proces umožňuje vytvořit menší, výkonnostně optimalizované verze modelu, které zachovají schopnosti velkého modelu, ale jsou provozně méně náročné. Distilace je důležitá z několika důvodů:

Tento přístup je užitečný také pro firmy, které potřebují schopnosti modelu na vysoké úrovni, ale nemají potřebný hardware pro provoz tak velkého modelu, jako je Llama-3.1 405B.

LLM-as-a-judge: Hodnocení kvality výstupů

Díky své robustní struktuře a výkonnostním vlastnostem může být model Llama-3.1 405B použit jako tzv. LLM-as-a-judge – tedy jako prostředek pro hodnocení kvality výstupů jiných jazykových modelů. Tato aplikace má velký význam v oblasti testování a vývoje modelů:

Použití Llama-3.1 jako hodnotícího modelu může výrazně snížit náklady a čas potřebný k testování jiných modelů, což je zvláště výhodné v prostředí, kde je kladen důraz na rychlé nasazení a vývoj.

Možnosti a doporučení pro jemné ladění a přizpůsobení

Llama-3.1 405B je plně přizpůsobitelný pro specifické potřeby různých oborů a odvětví. Umožňuje jemné ladění, což znamená, že firmy mohou model optimalizovat podle svého konkrétního využití:

Jemné ladění umožňuje Llama-3.1 405B přizpůsobit na míru a výrazně zvýšit její efektivitu v konkrétních aplikacích. Firmy tak získají přesněji laděné nástroje, které mohou využít pro lepší automatizaci procesů nebo zákaznickou zkušenost.

Technické požadavky pro nasazení Llama-3.1 405B

Model Llama-3.1 405B díky svému počtu parametrů vyžaduje vysoce výkonný hardware, zejména při inferenci a tréninku. Předpokladem pro úspěšné nasazení tohoto modelu je pečlivé plánování a optimalizace zdrojů, které zaručí jeho efektivní fungování bez přetížení systémů.

Paměťové nároky pro inference a trénink

Paměťové požadavky pro Llama-3.1 405B jsou jedním z hlavních faktorů, které mohou omezit jeho nasazení na běžně dostupném hardwaru. Zde jsou uvedeny odhadované požadavky pro spuštění modelu při různých úrovních kvantizace:

Tyto hodnoty ukazují, že i při nejnižší přesnosti (INT4) vyžaduje Llama-3.1 405B více než 200 GB VRAM, což je množství, které lze běžně najít pouze na specializovaných GPU serverech. Například pro nasazení s plnou 16bitovou přesností (FP16) je nutný hardwarový cluster s více GPU. Při kvantizaci modelu na FP8 nebo INT4 lze paměťové nároky výrazně snížit, avšak s menší přesností.

| Model Size | 1k tokens | 16k tokens | 128k tokens |

|---|---|---|---|

| 405B | 0.984 GB |

15.38 GB |

123.05 GB |

Paměťová kapacita KV Cache může být zásadní zejména při úlohách vyžadujících dlouhý kontext, kde je důležité uchovat co nejvíce dat v paměti bez nutnosti opakovaných výpočtů.

Výkon a optimalizace pomocí kvantizace

Kvantizace je důležitým nástrojem pro optimalizaci výkonu modelu a snížení jeho paměťových nároků. U modelu Llama-3.1 405B jsou dostupné možnosti kvantizace na FP8 a INT4, které mohou dramaticky snížit požadavky na VRAM a umožnit provoz modelu na menších nebo méně výkonných zařízeních.

Tyto optimalizace jsou klíčové pro firmy, které chtějí využít model Llama-3.1 405B, ale nemají přístup k high-end hardwarovým clusterům. Kvantizace umožňuje efektivní běh modelu i na omezených zdrojích, čímž rozšiřuje možnosti jeho nasazení na širší spektrum zařízení a aplikací.

Bezpečnost a odpovědné použití modelu Llama-3.1 405B

Společnost Meta věnovala velkou pozornost bezpečnostním funkcím modelu Llama-3.1 405B a jeho odpovědnému použití. Přístup k otevřeným modelům totiž přináší nejen výhody, ale i nové výzvy, pokud jde o bezpečnost, ochranu dat a integritu výstupů.

Přehled nástrojů pro bezpečné nasazení modelu Llama-3.1

Llama-3.1 405B je vybaven několika bezpečnostními funkcemi, které minimalizují rizika spojená s jeho používáním:

Tyto nástroje poskytují ochranu před potenciálními hrozbami a zajišťují, že model bude produkovat výstupy v souladu s etickými a bezpečnostními standardy, což je klíčové především pro nasazení v citlivých odvětvích.

Spolupráce s IBM Watsonx a odpovědná AI

Meta spolupracuje s IBM Watsonx, aby umožnila bezpečné a odpovědné nasazení modelů Llama v různých prostředích. IBM Watsonx poskytuje robustní infrastrukturu pro ladění, evaluaci a správu modelů, která umožňuje organizacím plně využít potenciál Llama-3.1 v souladu s osvědčenými postupy a bezpečnostními standardy.

Tato spolupráce navíc umožňuje vývojářům přístup k technologiím IBM pro Retrieval-Augmented Generation (RAG) a dalším metodám, které posilují důvěryhodnost a efektivitu modelu Llama-3.1 405B. Platforma IBM Watsonx podporuje robustní, flexibilní a odpovědné použití generativních AI modelů v podnikovém prostředí, čímž usnadňuje jejich přizpůsobení na specifické požadavky firemních aplikací.

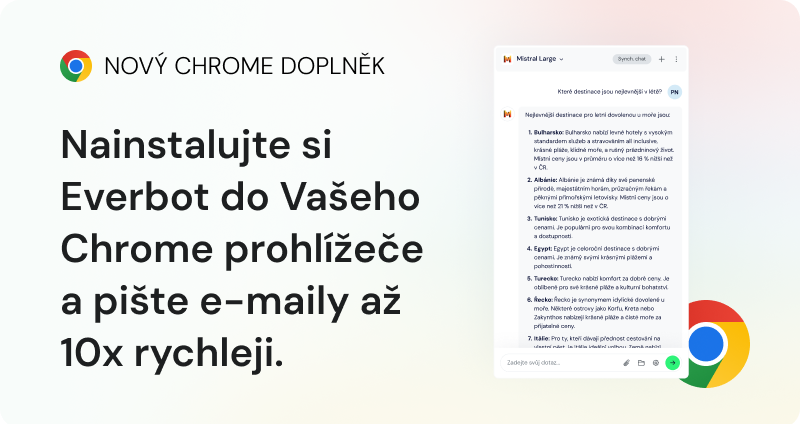

Vyzkoušejte aplikaci Everbot bez závazků a bez rizika

Ušetřete až 6+ hodin denně a tvořte obsah, který prodává, s Everbotem na pár kliknutí.